Per volare in sicurezza

|

Per volare in sicurezza |

|

limiti, pregi e difetti

Spiegheremo in questo articolo il funzionamento

di un modello fisico-matematico, partendo

dalla sua struttura essenziale per evolvere e perderci in quei meandri di equazioni che

lo rendono il più elaborato e complesso sistema operativo in grado di avvicinarsi

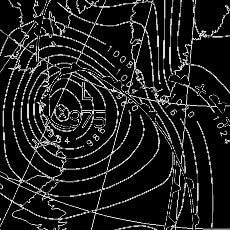

il più possibile all’esatta evoluzione dell’atmosfera.  Cominciamo dal reticolato geografico. Non stiamo parlando di latitudine e longitudine, ma di una struttura “a cella quadrata” che virtualmente ricopre buona parte del nostro pianeta, distribuita orizzontalmente e su 31 livelli verticali dal suolo fino a 30 Km di altezza. Ai vertici di queste celle, nei punti di giunzione, sono poste piccole stazioni meteorologiche (i palloni sonda lanciati dai centri meteorologici) che, ogni sei ore, rilevano le misure dei parametri che descrivono lo stato iniziale dell’atmosfera in quell’istante. Poiché il nostro pianeta è occupato per la maggior parte dagli oceani, sulla verticale di un punto che si trova ad esempio nel bel mezzo dell’Oceano non si potranno sapere i dati relativi a quella colonna di atmosfera. Lo stesso discorso vale anche per la terraferma, in particolare per quelle zone inospitali dove la tecnologia scientifica non ha potuto approdare: mi riferisco in particolare ai deserti, o alle zone polari. In sintesi, quindi, per conoscere l’evoluzione del tempo, bisogna partire dallo stato iniziale dell’atmosfera, individuabile con le misure effettuate dalle suddette stazioni terrestri e aeree. Da quanto detto però, si evince che il primo errore è stato involontariamente commesso, dal momento che già in partenza non si riesce a conoscere l’esatto punto da cui iniziare per descrivere l’evoluzione futura. I parametri misurati sono in tutto sei: la velocità del vento (tre misure), la pressione, la temperatura e l’umidità dell’aria. Le ultime tre sono grandezze scalari (individuabili cioè da un numero), mentre il vento è una grandezza vettoriale che, per essere individuata, necessita di una terna di numeri riferiti alle tre coordinate spaziali disposte secondo una terna di assi x, y e z. I sei parametri sono interdipendenti, vale a dire che il cambiamento di uno provoca una reazione a catena sugli altri: un po’ come la banale legge dei gas secondo cui il prodotto tra pressione e volume deve essere costante. In ogni punto del reticolato il pallone sonda quindi misura i valori di questi sei parametri e li comunica ai centri di calcolo per studiare l’evoluzione prossima dell’atmosfera. Quando tutto il reticolato dispone dei dati misurati, si dà il via alle operazioni mediante l’utilizzo di un sistema di sei equazioni, ciascuna delle quali individua la probabile evoluzione per ogni grandezza. Poiché ad ogni nodo del reticolo è quindi associato un sistema di sei equazioni in sei incognite, si calcola che le equazioni che simultaneamente il centro di calcolo deve eseguire sono oltre 30 milioni. Ma non è certamente così semplice: i problemi vengono proprio ora. Non abbiamo tenuto presente, infatti, altri imprevisti che devono essere tenuti in conto nella risoluzione di tali equazioni. Pur restando solo sei i parametri misurati, bisogna considerare, ad esempio, anche le turbolenze atmosferiche, o la quantità di moto tra strati contigui dell’atmosfera. Queste nuove considerazioni di certo non trascurabili finiscono solo per complicare il lavoro dei centri di calcolo. Le equazioni quindi si complicano e “salgono di grado”: non sono più equazioni lineari con unica soluzione, ma diventano equazioni che ammettono più soluzioni, dal momento che le diverse grandezze finiscono anche per moltiplicarsi tra loro. In realtà il discorso è ancora più difficile, perché bisognerebbe parlare di equazioni fisiche differenziali, ma in sede è meglio sorvolare per non complicare ulteriormente i concetti. Arriviamo quindi al punto in cui il “cervellone”, nell’elaborazione dei dati, ha a che fare con la risoluzione di oltre 30 milioni di equazioni di grado che, per fare un esempio, poniamo uguale a quattro. Essendo un numero abnorme di equazioni, il modello matematico (il cervellone di calcolo) comincia a semplificare le suddette equazioni, abbassandole di grado e portandole magari al livello tre: ora da ogni equazione otteniamo tre soluzioni e non quattro. E questo è il secondo errore che si compie: abbassando il grado dell’equazione di perdono milioni di soluzioni. Ci ritroviamo ora 30 milioni di equazioni, ciascuna con tre soluzioni: in tutto sono quindi 90 milioni di soluzioni che costituiscono quello che chiamiamo l’evoluzione delle condizioni atmosferiche per le prossime ore o i prossimi giorni, secondo fin dove ci si vuole spingere con la previsione. Come sono distribuite queste soluzioni? Letteralmente a casaccio, ma presenteranno punti in cui si addenseranno: lì esiste la più alta probabilità che la previsione sia rispettata. A questo punto entra in scena il previsore. Dopo aver seguito passo passo questo rompicapo di calcoli ed equazioni, analizza quei punti in cui si concentrano le soluzioni ed emette il suo verdetto in conformità a quanto dicono quelle soluzioni. Come potrete osservare, viene compiuto un altro errore, poiché sono sottovalutati altri dati previsionali che derivano dalle soluzioni contigue a quelle prese in esame. Tirando quindi le somme, circa un terzo delle soluzioni viene trascurato in partenza e tra le rimanenti ne sono utilizzate una parte. Ecco in realtà come funziona un modello! Ecco il lavoro e la mole di calcoli cui è soggetto ogni giorno! In conclusione, vi pongo allora tre domande. Possiamo essere certi che, dopo aver consultato un modello, la previsione sia corretta sotto ogni punto di vista? E’ giusto affermare che i modelli godono in un certo senso di una propria immunità, visto che ancora oggi non si conoscono del tutto le leggi fisiche che regolano la nostra atmosfera? E’ lecito che il modello matematico possa ritrattare quanto preventivato, essendo soggetto al caos che regna nell’atmosfera? Solo ora, dopo aver affrontato il problema, si riesce realmente a comprendere le difficoltà cui si deve andare incontro un meteorologo una volta analizzata la futura evoluzione del tempo. Si tratta di una previsione che è basata essenzialmente sulla considerazione che l’evento “x” possa verificarsi con una probabilità maggiore rispetto all’evento “y”, e quindi qui cade la scelta, visto che nessuno, almeno credo, finirebbe per proporre un fenomeno la cui probabilità è magari ridotta al lumicino. A volte però questo tipo di approccio alla risoluzione dei modelli appare sbagliato, ed ecco che allora il tempo atmosferico prediligerà un’altra soluzione rispetto a quella più gettonata. E’ plausibile però anche questa scelta, perché forse tra le milioni di soluzioni trascurate nelle approssimazioni iniziali ci potrebbero essere state anche quelle che avvaloravano l’ipotesi lasciata in disparte. Si può quindi capire, a grandi linee, che una previsione del tempo non è certo solo una questione di osservazione: non basta osservare il cielo o un barometro per assicurare che domani sarà bello, assolutamente no! Il complicato e soprattutto laborioso metodo di elaborazione dei calcoli ci può far riflettere un istante, quanto basta per interrompere tutta una serie di tiri al bersaglio ogni qualvolta una previsione appare sbagliata. Facciamo ora degli esempi concreti e terminiamo parlando dei limiti oltre i quali il modello non può spingersi. A sbarrare la strada verso un’evoluzione più esatta ci pensa la matematica. Anche se si raffinasse il più possibile il modello, rimarrebbe sempre un margine di errore in grado di sconvolgere l’evoluzione più probabile. Per rendere più chiara l’idea, supponiamo di avere un’equazione di ottavo grado già scomposta in fattori e cerchiamo di risolverla: (a-1)*(b-2)*(c-3/2)*(d-1/5)*(3e-1/9)*(7f-2)*(g-1/4)*(h+3) = 0 Applicando la regola dell’annullamento del prodotto (un prodotto è nullo se almeno uno dei suoi fattori è zero), si trovano le seguenti soluzioni: a=1 ; b=2 ; c=3/2 ; d=1/5 ; e=1/27 ; f=2/7 ; g=1/4 ; h=-3 Supponiamo ora di classificare le soluzioni trovate in due insiemi: le soluzioni positive nell’insieme A e quelle negative in B. Se etichettiamo con “bel tempo” il primo insieme e con “maltempo” il secondo, vediamo che maggiori soluzioni cadranno nell’insieme A, dove regna il tempo stabile. Come interpretare questo risultato? Rapportando a 100 le soluzioni totali (in questo caso sono 8), allora la probabilità che la previsione “Domani sarà bello” si verifichi è pari all’87.5% contro un solo 12.5% di probabilità che invece venga a piovere. A questo punto pongo a voi una domanda. Se vi doveste improvvisare meteorologi e se aveste tra le mani i dati percentuali che vi ho appena fornito, quale comportamento adottereste a riguardo? Sareste propensi ad emettere il verdetto “Domani sarà bello” (87.5% di probabilità di successo) o direste “Domani uscite con l’ombrello” (12.5% di probabilità che ci azzecchiate)? Ecco il grande dilemma dei previsori: essere del tutto vincolati da una misura percentuale che, in sé, è il frutto di un puro calcolo analitico. Fin tanto che i dati sono questi la scelta non è cero difficile, ma se poi le percentuali si avvicinano e tra loro si discostano di poco, allora diventa ancor più complesso emettere una previsione che sia più corretta possibile, perché di pari merito aumenta a dismisura anche il rischio di sbagliare. Come comportarsi allora? Fermi restando che il modello è l’unico mezzo disponibile che possa illuminare le menti dei meteorologi, a volte bisogna basarsi sull’esperienza: si vanno quindi a cercare nel passato tutte quelle situazioni analoghe che si sono proposte e da qui, osservando la reale evoluzione che proprio in quelle occasioni si è verificata, si emette la sentenza definitiva. Si sa però che dal punto di vista orografico la penisola italiana costituisce uno dei territori più difficili e complessi da analizzare; in modo particolare si tratta di un territorio che presenta un elaborato adattamento ai modelli fisico-matematici. Ed è proprio per questa ragione, non certo di poco conto, che le nostre previsioni sono tra le più complicate dell’intero continente europeo e forse anche di quello americano, qualunque esso sia il responso dei centri di calcolo. In poche parole possiamo sostenere che l’Italia è il tipico paese per cui una previsione va letteralmente stillata. Oltre al fattore orografico, in ogni caso, esiste un secondo contributo che tende ad amplificare le già difficili operazioni di calcolo dei modelli stessi: si tratta del bacino del Mediterraneo, un’enorme massa d’acqua la cui temperatura, in media, supera di circa quattro gradi quella del vicino Atlantico. Tradotto in termini energetici, ciò equivale a ricordare che il Mediterraneo rappresenta per le masse d’aria in circolo ciò che l’ossigeno rappresenta per un fuoco che si sta spegnendo per soffocamento: costituisce cioè l’energia necessaria per intensificare i fenomeni atmosferici e tutti i processi che li causano e li determinano. E non è poco. Vediamo infine i limiti. Si parla di “modello fisico-matematico”. Cosa significa? Significa avere un “qualcosa” che sforna un’elaborazione, basata sui principi e leggi fisiche rappresentate mediante formule matematiche (equazioni a derivate parziali miste e di grado elevato). E’ qui il grande dilemma: associare un’osservazione “fisica” (ovvero le misure effettuate mediante i radiosondaggi, ecc…) ad una formula matematica che ne rappresenti l’evoluzione futura. Non so se mi sono spiegato. L’errore sta proprio nel fare questa associazione che, purtroppo appare obbligatoria. Non c’è altro mezzo per conoscere un’evoluzione più precisa possibile. Perché sta qui l’errore? Perché la matematica è una disciplina che si autodefinisce, cioè che parte da un qualcosa già noto alle spalle e su cui non si discute. E’ così e basta. Ecco perché fisici e matematici non vanno tanto d’accordo. Siete mai riusciti a dimostrare la tesi di un teorema senza partire dalle ipotesi? No davvero! Cosa vuol dire dimostrare un qualcosa partendo da un altro qualcosa che va preso per buono? E portare a termine una dimostrazione usando solo dogmi? Purtroppo le equazioni matematiche che interagiscono nei modelli seguono questo principio, per cui ci troviamo ad esempio una derivata parziale di terzo grado legata alla temperatura combinata una derivata parziale di secondo grado legata al vento. Perché è proprio questa la combinazione? Risposta: perché i calcoli dicono che è così… Questo, se ci ragionate bene, è il motivo per cui un modello è differente dall’altro (ECMWF, GFS, BRACKNELL…) Magari uno segue una combinazione ed un certo ordine di derivate, un altro segue invece un altro. Riuscite a capire? Con questo non ho intenzione certamente di disabilitare un modello fisico matematico. Teniamoceli belli cari e usiamo cervello, quando li osserviamo e cerchiamo di commentarli. E ricordiamoci sempre che essi rappresentano solo la probabilità di un evento. In questa ottica sarebbe perfino errato parlare di previsione del tempo: sarebbe più giusto dire che avremo una probabilità del “tot”% che si verifichi quel fenomeno. Sarebbe anche giusto capire che una probabilità dell’85% di tempo buono non dà quell’assoluta certezza che tutti si aspetterebbero: gli errori che ci portiamo eternamente dietro ed i limiti del modello stesso contribuiscono (e non poco) ad instabilizzare anche una certezza data quasi per scontata. Ho scritto tutto questo con la speranza di evitare, una volta per tutte, quei giudizi di colpevolezza che il più delle volte, fin troppo alla leggera, vengono emessi nei confronti del più autorevole mezzo scientifico di cui disponiamo. Cerchiamo di capire il modello, fino in fondo. Non limitiamoci a commentare due isoipse e, soprattutto, non lasciamoci entusiasmare dall’aspetto puramente cromatico che tanto ci fa impazzire quando assume le tonalità azzurre e poi violette…

Andrea Corigliano

|